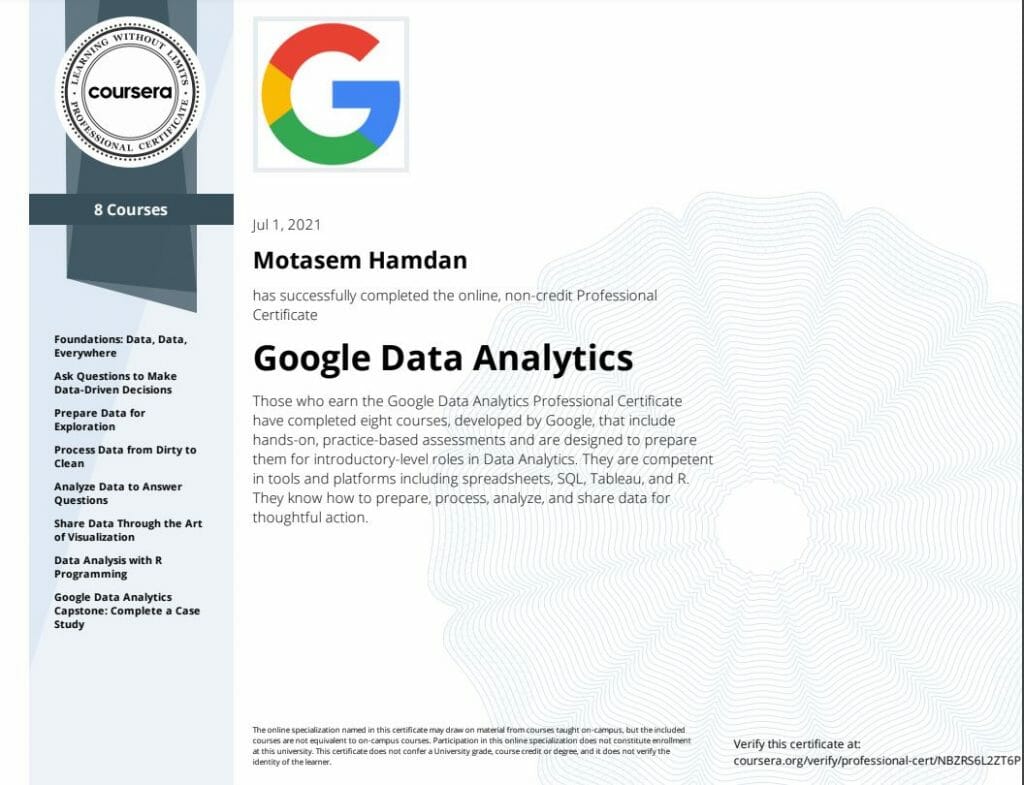

Aujourd'hui j'ai fini le Certificat professionnel Google Data Analytics

proposé par Google et Coursera et j'aimerais proposer mon avis et mes notes de cours.

Il y a huit cours que vous devez terminer avant d'obtenir le certificat final :

- Fondements : des données, des données, partout

- Posez des questions pour prendre des décisions basées sur les données

- Préparer les données pour l'exploration

- Traiter les données de sales à propres

- Analyser les données pour répondre aux questions

- Partagez des données grâce à l'art de la visualisation

- Analyse des données avec la programmation R

- Capstone de Google Data Analytics : réaliser une étude de cas

Compétences que vous gagnerez

-

Acquérir une compréhension immersive des pratiques et des processus utilisés par un analyste de données junior ou associé dans son travail quotidien

-

Apprenez les compétences analytiques clés (nettoyage, analyse et visualisation des données) et les outils (feuilles de calcul, SQL, programmation R, Tableau)

-

Comprendre comment nettoyer et organiser les données à des fins d'analyse, et effectuer des analyses et des calculs à l'aide de feuilles de calcul, de la programmation SQL et R.

-

Apprenez à visualiser et à présenter les résultats des données dans des tableaux de bord, des présentations et des plateformes de visualisation couramment utilisées.

Achetez le catalogue complet de notes d'analyse de données

Le certificat final

Si j'ai également ajouté mes notes et mon résumé pour chaque cours, y compris des extraits de code, des concepts et d'autres éléments dont vous pourriez avoir besoin pour réussir le cours, résumez ce que vous avez appris et conservez les notes car elles peuvent s'avérer utiles lorsque vous en avez besoin.

Vous pouvez télécharger ma collection de résumés et de notes à partir des liens ci-dessous :

Revue vidéo

Résumé des concepts que vous apprendrez :

# Les six étapes du processus d'analyse des données

Posez des questions et définissez le problème.

Préparez les données en collectant et en stockant les informations.

Traiter les données en nettoyant et en vérifiant les informations.

Analysez les données pour trouver des modèles, des relations et des tendances.

Partagez des données avec votre public.

Agir sur les données et utiliser les résultats d’analyse.

Écosystème de données #

Les différents éléments qui interagissent les uns avec les autres pour produire, gérer, stocker, organiser, analyser et partager des données.

# Un esprit technique

La compétence analytique qui implique de décomposer les processus en étapes plus petites et de travailler avec elles de manière ordonnée et logique

Conception des données #

Compétences analytiques qui impliquent la façon dont vous organisez l’information

# Science des données

Un domaine d'étude qui utilise des données brutes pour créer de nouvelles façons de modéliser et de comprendre l'inconnu

Stratégie de données #

La gestion des personnes, des processus et des outils utilisés dans l'analyse des données

Analyse des écarts #

Une méthode pour examiner et évaluer l'état actuel d'un processus afin d'identifier les opportunités d'amélioration dans le futur.

Langage de requête #

Un langage de programmation informatique utilisé pour communiquer avec une base de données

Cycle de vie des données # vs analyse des données

Le cycle de vie des données traite des étapes par lesquelles passent les données au cours de leur durée de vie utile ; l'analyse des données est le processus d'analyse des données.

Formule # vs fonction

Une formule est un ensemble d'instructions utilisées pour effectuer un calcul spécifié ; une fonction est une commande prédéfinie qui exécute automatiquement un processus spécifié

# Les six problèmes avec lesquels un analyste de données travaille :

Faire des prédictions

Catégoriser les choses

###### Un analyste de données identifiant les mots-clés des avis clients et les étiquetant comme positifs ou neutres est un exemple de catégorisation des choses.

Repérer quelque chose d'inhabituel

###### Le type de problème consistant à repérer quelque chose d'inhabituel pourrait impliquer qu'un analyste de données examine pourquoi un ensemble de données contient un point de données surprenant et rare. Repérer quelque chose d'inhabituel consiste à identifier et analyser quelque chose qui sort de l'ordinaire.

-Identifier les thèmes

###### Les concepteurs d'expérience utilisateur (UX) peuvent s'appuyer sur des analystes pour analyser les données d'interaction des utilisateurs. À l’instar des problèmes qui nécessitent que les analystes catégorisent les éléments, les projets d’amélioration de la convivialité peuvent nécessiter que les analystes identifient des thèmes pour aider à prioriser les fonctionnalités du produit à améliorer. Les thèmes sont le plus souvent utilisés pour aider les chercheurs à explorer certains aspects des données. Dans une étude utilisateur, les croyances, les pratiques et les besoins des utilisateurs sont des exemples de thèmes.

###### Vous vous demandez peut-être s'il existe une différence entre catégoriser des choses et identifier des thèmes. La meilleure façon d'y penser est la suivante : catégoriser les choses classe généralement les mêmes choses ensemble, comme un score de produit de 10, tandis que l'identification des thèmes classe les choses similaires. des choses qui peuvent ne pas être les mêmes, comme les commentaires positifs des utilisateurs ; chaque utilisateur dit quelque chose de différent, mais il communique des choses positives sur le produit, qui devient un thème.-Découvrir les connexions

-Trouver des modèles

###### La recherche de modèles consiste à identifier les tendances dans un ensemble de données.

Les questions intelligentes # sont :

-spécifique : la question a-t-elle un contexte et aborde-t-elle le problème. et les réponses aident-elles à collecter des informations

à un élément spécifique ou à des éléments étroitement liés.

-mesurable : les réponses peuvent être mesurées et collectées pour être classées et notées afin de voir lesquelles sont les plus et les moins

important

-orienté vers l'action : lorsqu'on lui répond, il aide à prendre des décisions axées sur la résolution d'un problème spécifique ou sur l'invention

nouvelle fonctionnalité.

-pertinent : s'agit-il du problème ?

-limité dans le temps : les réponses résoudront-elles le problème le plus tôt possible ? un plan peut-il être créé pour mettre en œuvre

les solutions que les acheteurs préfèrent et réduisent les fonctionnalités les moins importantes ?

# Pensée structurée

Révéler les lacunes et les opportunités

Reconnaître le problème ou la situation actuelle

Organiser les informations disponibles

# Catégoriser les choses implique d'attribuer des éléments à des catégories. L'identification des thèmes va encore plus loin dans ces catégories, en les regroupant en thèmes ou classifications plus larges.

Données qualitatives et quantitatives #

Les données qualitatives peuvent aider les analystes à mieux comprendre leurs données quantitatives en fournissant une raison ou une explication plus approfondie. En d’autres termes, les données quantitatives vous donnent généralement le quoi, et les données qualitatives vous donnent généralement le pourquoi.

Les tableaux de bord # surveillent les données entrantes en direct à partir de plusieurs ensembles de données et organisent les informations dans un emplacement central.

Données # et métriques

Les données sont un ensemble de faits. Les métriques sont des types de données quantifiables utilisés pour la mesure

Algorithme #

un processus ou un ensemble de règles à suivre pour une tâche spécifique

# Métrique

Une métrique est un type de données unique et quantifiable utilisé lors de la définition et de l’évaluation des objectifs.

# La pensée structurée est le processus consistant à reconnaître le problème ou la situation actuelle, à organiser les informations disponibles, à révéler les lacunes et les opportunités et à identifier les options.

# Fonction vs formule

Les formules sont créées par l'utilisateur, tandis que les fonctions sont des commandes prédéfinies dans des feuilles de calcul

# Les quatre questions pour une stratégie de communication efficace (principalement utilisées dans les emails)

Quel est votre public ?

Que savent-ils déjà ?

Que doivent-ils savoir ?

Comment pouvez-vous communiquer au mieux ce qu’ils ont besoin de savoir ?

Données de première partie #

Données que vous collectez vous-même

Données de seconde partie #

Les données qui sont collectées directement par un autre groupe puis vendues.

Données tierces #

Les données tierces peuvent provenir de plusieurs sources différentes.

Les données tierces sont vendues par un fournisseur qui n'a pas collecté les données lui-même.

# Si vous collectez vos propres données, prenez des décisions raisonnables concernant la taille de l'échantillon

# Un échantillon aléatoire à partir de données existantes peut convenir à certains projets

# L’observation est la méthode de collecte de données la plus souvent utilisée par les scientifiques.

Données primaires #

Recueilli par un chercheur à partir de sources de première main

ex : Données d'un entretien que vous avez mené

# Données secondaires

Recueillis par d'autres personnes ou à partir d'autres recherches

Données démographiques collectées par une université

# Données continues

Données mesurées et pouvant avoir presque n'importe quelle valeur numérique

Taille des enfants des classes de troisième année (52,5 pouces, 65,7 pouces)

# Données discrètes

Données comptées et ayant un nombre limité de valeurs

Nombre de personnes qui visitent quotidiennement un hôpital (10, 20, 200)

Données nominales #

Un type de données qualitatives qui ne sont pas classées selon un ordre défini

Premier client, client fidèle, client régulier

Données ordinales #

Un type de données qualitatives avec un ordre ou une échelle définie

Classements des films (nombre d'étoiles : 1 étoile, 2 étoiles, 3 étoiles)

# Données structurées

Données organisées dans un certain format, comme des lignes et des colonnes

Rapports de dépenses

# Données non structurées

Données qui ne sont pas organisées de manière facilement identifiable

Publications sur les réseaux sociaux

# La modélisation des données est le processus de création de diagrammes qui représentent visuellement la manière dont les données sont organisées et structurées.

Ces représentations visuelles sont appelées modèles de données

Types de modélisation de données #

###### La modélisation conceptuelle des données vous offre une vue de haut niveau de votre structure de données, par exemple la manière dont vous souhaitez que les données interagissent au sein d'une organisation.

###### La modélisation logique des données se concentre sur les détails techniques du modèle, tels que les relations, les attributs et les entités.

###### La modélisation des données physiques doit en réalité décrire la façon dont la base de données a été construite. À ce stade, vous définissez comment chaque base de données sera mise en place et comment les bases de données, les applications et les fonctionnalités interagiront de manière spécifique.

Techniques de modélisation des données #

Les ERD sont un moyen visuel de comprendre la relation entre les entités dans le modèle de données

Les UML sont des diagrammes très détaillés qui décrivent la structure d'un système en montrant les entités, les attributs, les opérations et les relations du système.

# La transformation des données est le processus de modification du format, de la structure ou des valeurs des données.

# Les données longues sont des données dans lesquelles chaque ligne est un point de données pour un sujet individuel. Chaque sujet contient des données sur plusieurs lignes.

# Les données larges sont des données dans lesquelles chaque personne concernée dispose d'une seule ligne avec plusieurs colonnes pour les valeurs des différents attributs (ou variables) de la personne concernée.

# L'opérateur booléen Ou augmente le nombre de résultats lorsqu'il est utilisé dans une recherche par mot clé

Désidentification #

Un processus utilisé pour effacer les données de toutes les informations d'identification personnelle

# Une base de données relationnelle est une base de données qui contient une série de tables qui peuvent être connectées pour afficher les relations.

Fondamentalement, ils permettent aux analystes de données d'organiser et de relier les données en fonction de ce qu'elles ont en commun.

# Une base de données relationnelle est une base de données qui contient une série de tables qui peuvent être connectées pour afficher les relations.

Fondamentalement, ils permettent aux analystes de données d'organiser et de relier les données en fonction de ce qu'elles ont en commun.

Clé primaire #

Un identifiant unique dans une table qui fait référence à une colonne où la valeur de cette clé dans chaque ligne est unique.

# Clé étrangère

Un champ dans une table et est une clé primaire dans une autre table.

# Une table ne peut avoir qu'une seule clé primaire, mais elle peut avoir plusieurs clés étrangères.

Ces clés créent les relations entre les tables dans une base de données relationnelle,

ce qui permet d'organiser et de connecter les données sur plusieurs tables de la base de données.

# La normalisation d'une base de données est une technique permettant de réduire la redondance des données

# Un schéma est une manière de décrire comment quelque chose est organisé

# Un schéma de base de données représente tout type de structure appliquée à la base de données

# Deux schémas couramment utilisés sont les schémas en étoile et les schémas en flocon de neige.

Le schéma en étoile # est simple, n'est pas normalisé et présente une grande redondance des données

# Un schéma en flocon de neige est complexe, normalisé et comporte très peu de données redondantes.cy

Histogramme #

Un histogramme est efficace pour démontrer les différences entre plusieurs éléments dans une plage de valeurs spécifique.

Diagramme linéaire #

Les graphiques linéaires sont efficaces pour démontrer les tendances et les modèles, tels que l'évolution de la population au fil du temps.

Les métadonnées structurelles # indiquent exactement dans combien de collections se trouvent les données.

Il fournit des informations sur la façon dont une donnée est organisée et si elle fait partie d'une ou de plusieurs collectes de données.

La gouvernance des données # garantit que les actifs de données d'une entreprise sont correctement gérés.

# La date et l'heure de création d'une base de données sont un exemple de métadonnées administratives.

La tokenisation # remplace les éléments de données que vous souhaitez protéger par des données générées aléatoirement appelées « jeton ».

Les données originales sont stockées dans un emplacement distinct et mappées aux jetons.

Pour accéder aux données originales complètes, l'utilisateur ou l'application doit avoir l'autorisation d'utiliser les données tokenisées et le mappage de jetons.

Cela signifie que même si les données tokenisées sont piratées, les données originales sont toujours en sécurité dans un emplacement distinct.

**Les analystes de données devraient penser à modifier un objectif métier lorsque les données ne correspondent pas à l'objectif initial et lorsqu'il n'y a pas suffisamment de données pour atteindre l'objectif**

**Les données utilisées pour l'analyse doivent correspondre aux objectifs commerciaux et aider à répondre aux questions des parties prenantes**

# Que faire lorsque vous rencontrez un problème avec vos données

## Problème de données 1 : aucune donnée

Si vous n'avez pas le temps de collecter des données, effectuez l'analyse à l'aide de données proxy provenant d'autres ensembles de données. _Il s'agit de la solution de contournement la plus courante._

Si vous analysez les heures de pointe pour les navetteurs mais que vous ne disposez pas de données pour une ville particulière, utilisez les données d'une autre ville de taille et de données démographiques similaires.

## Problème de données 2 : trop peu de données

Effectuez l'analyse en utilisant des données proxy ainsi que des données réelles.

Si vous analysez les tendances des propriétaires de golden retrievers, agrandissez votre ensemble de données en incluant les données des propriétaires de labradors.

Ajustez votre analyse pour l’aligner sur les données dont vous disposez déjà.

S'il vous manque des données pour les 18 à 24 ans, effectuez l'analyse mais notez la limite suivante dans votre rapport : _cette conclusion s'applique aux adultes de 25 ans et plus_ _uniquement_.

## Problème de données 3 : données erronées, y compris les données contenant des erreurs

Solutions possibles

Si vous disposez de données erronées parce que les exigences ont été mal comprises, communiquez à nouveau les exigences.

Si vous avez besoin des données sur les électrices et que vous avez reçu les données sur les électeurs masculins, reformulez vos besoins.

Identifiez les erreurs dans les données et, si possible, corrigez-les à la source en recherchant une tendance dans les erreurs.

Si vos données se trouvent dans une feuille de calcul et qu'il existe une instruction conditionnelle ou un booléen provoquant des erreurs dans les calculs, modifiez l'instruction conditionnelle au lieu de simplement corriger les valeurs calculées.

Si vous ne pouvez pas corriger vous-même les erreurs de données, vous pouvez ignorer les données erronées et poursuivre l'analyse si la taille de votre échantillon est encore suffisamment grande et que le fait d'ignorer les données ne provoquera pas de biais systématique.

Si votre ensemble de données a été traduit à partir d'une autre langue et que certaines traductions n'ont pas de sens, ignorez les données mal traduites et poursuivez l'analyse des autres données.

![[Data-collection-notes.jpg]]

**Population**

L'ensemble du groupe qui vous intéresse pour votre étude. Par exemple, si vous enquêtez auprès des personnes de votre entreprise, la population serait constituée de tous les employés de votre entreprise.

**Échantillon**

Un sous-ensemble de votre population. Tout comme un échantillon de nourriture, on l’appelle un échantillon car il ne s’agit que d’un avant-goût. Ainsi, si votre entreprise est trop grande pour interroger chaque individu, vous pouvez interroger un échantillon représentatif de votre population.

**Marge d'erreur**

Puisqu'un échantillon est utilisé pour représenter une population, les résultats de l'échantillon sont censés différer de ce qu'ils auraient été si vous aviez interrogé l'ensemble de la population. Cette différence s’appelle la marge d’erreur. Plus la marge d’erreur est petite, plus les résultats de l’échantillon sont proches de ce qu’ils auraient été si vous aviez interrogé l’ensemble de la population.

La marge d'erreur est utilisée pour déterminer dans quelle mesure le résultat de votre échantillon est proche de ce qu'il aurait probablement été si vous aviez pu enquêter ou tester l'ensemble de la population. La marge d'erreur vous aide à comprendre et à interpréter les résultats d'enquêtes ou de tests dans la vie réelle. Le calcul de la marge d’erreur est particulièrement utile lorsque vous disposez des données à analyser. Après avoir utilisé une calculatrice pour calculer la marge d'erreur, vous saurez dans quelle mesure les résultats de l'échantillon peuvent différer des résultats de l'ensemble de la population.

**Un niveau de confiance**

Dans quelle mesure avez-vous confiance dans les résultats de l’enquête. Par exemple, un niveau de confiance de 95% signifie que si vous deviez exécuter la même enquête 100 fois, vous obtiendriez des résultats similaires 95 de ces 100 fois. Le niveau de confiance est ciblé avant de commencer votre étude, car il affectera l'ampleur de votre marge d'erreur à la fin de votre étude.

Dans la plupart des cas, un niveau de confiance 90% ou 95% est utilisé. Mais, en fonction de votre secteur d’activité, vous souhaiterez peut-être définir un niveau de confiance plus strict. Un niveau de confiance 99% est raisonnable dans certaines industries, comme l'industrie pharmaceutique.

**Intervalle de confiance**

La plage de valeurs possibles que serait le résultat de la population au niveau de confiance de l'étude. Cette plage correspond au résultat de l'échantillon +/- la marge d'erreur.

**Signification statistique**

La détermination de savoir si votre résultat pourrait être dû au hasard ou non. Plus l’importance est grande, moins elle est due au hasard.

**Pour qu'une expérience soit statistiquement significative, les résultats doivent être réels et non le fruit du hasard.**

**Afin d'avoir un niveau de confiance élevé dans une enquête auprès des clients, la taille de l'échantillon doit refléter avec précision l'ensemble de la population.**

## Types de données sales

Données en double

Données obsolètes

Données incomplètes

Données incorrectes/inexactes

Données incohérentes

**Une valeur nulle indique qu'une valeur n'existe pas. Un zéro est une réponse numérique.**

**Le mappage de données est le processus de mise en correspondance des champs d'une source de données à une autre.**

Documentation #

Les ingénieurs utilisent des **ordres de modification technique** (ECO) pour suivre les détails de conception des nouveaux produits et les modifications proposées aux produits existants. Les rédacteurs utilisent des **historiques de révision de documents** pour suivre les modifications apportées au flux de documents et aux modifications. Et les analystes de données utilisent les **changelogs** pour suivre la transformation et le nettoyage des données.

Les journaux des modifications sont très utiles pour nous aider à comprendre les raisons pour lesquelles des modifications ont été apportées. Les journaux des modifications n'ont pas de format défini et vous pouvez même effectuer vos entrées dans un document vierge. Mais si vous utilisez un journal des modifications partagé, il est préférable de se mettre d'accord avec d'autres analystes de données sur le format de toutes vos entrées de journal.

Un analyste junior n’a probablement besoin de connaître que ce qui précède, à une exception près. Si un analyste apporte des modifications à une requête SQL existante partagée dans toute l'entreprise, celle-ci utilise très probablement ce qu'on appelle un **système de contrôle de version**. Un exemple pourrait être une requête qui extrait les revenus quotidiens pour créer un tableau de bord pour la haute direction.

Système de contrôle de version #

Voici comment un système de contrôle de version affecte une modification apportée à une requête :

1. Une entreprise dispose de versions officielles des requêtes importantes dans son **système de contrôle de version**.

2. Un analyste s'assure que la version la plus à jour de la requête est celle qu'il va modifier. C'est ce qu'on appelle la **synchronisation**

3. L'analyste apporte une modification à la requête.

4. L'analyste peut demander à quelqu'un d'examiner ce changement. C'est ce qu'on appelle une **révision de code** et peut être effectuée de manière informelle ou formelle. Un examen informel pourrait être aussi simple que de demander à un analyste principal d'examiner le changement.

5. Une fois qu'un réviseur a approuvé la modification, l'analyste soumet la version mise à jour de la requête à un référentiel dans

6. le système de contrôle de version de l'entreprise. C'est ce qu'on appelle une **validation de code**. Une bonne pratique consiste à documenter exactement la nature du changement et pourquoi il a été effectué dans une zone de commentaires. Pour revenir à notre exemple de requête qui génère des revenus quotidiens, un commentaire pourrait être : _Revenus mis à jour pour inclure les revenus provenant du nouveau produit, Calypso_.

7. Une fois la modification **soumise**, tous les autres membres de l'entreprise pourront accéder et utiliser cette nouvelle requête lorsqu'ils se **synchroniseront** avec les requêtes les plus récentes stockées dans le système de contrôle de version.

8. Si la requête présente un problème ou si les besoins de l'entreprise changent, l'analyste peut **_annuler_** la modification apportée à la requête à l'aide du système de contrôle de version. L'analyste peut consulter une liste chronologique de toutes les modifications apportées à la requête et de la personne qui a effectué chaque modification. Ensuite, après avoir trouvé sa propre modification, l'analyste peut **revenir** à la version précédente.

9. La requête est revenue à ce qu’elle était avant que l’analyste n’effectue la modification. Et tout le monde dans l’entreprise voit également cette requête originale inversée.

Sans suffisamment de données pour identifier les tendances à long terme, une option consiste à discuter avec les parties prenantes et à leur demander d’ajuster l’objectif. Vous pouvez également demander d'attendre plus de données et de fournir un calendrier mis à jour.

**Les valeurs aberrantes** sont des points de données très différents des données collectées de manière similaire et qui peuvent ne pas constituer des valeurs fiables.

## Tri versus filtrage

Le **tri** consiste à organiser les données dans un ordre significatif pour les rendre plus faciles à comprendre, à analyser et à visualiser. Il classe vos données en fonction d'une métrique spécifique que vous choisissez. Vous pouvez trier les données dans des feuilles de calcul, des bases de données SQL (lorsque votre ensemble de données est trop volumineux pour les feuilles de calcul) et des tableaux dans des documents.

Par exemple, si vous devez classer des éléments ou créer des listes chronologiques, vous pouvez les trier par ordre croissant ou décroissant. Si vous souhaitez connaître les films préférés d'un groupe, vous pouvez trier par titre de film pour le découvrir. Le tri organisera les données de manière significative et vous donnera des informations immédiates. Le tri vous aide également à regrouper des données similaires selon une classification. Pour les films, vous pouvez les trier par genre, comme l'action, le drame, la science-fiction ou la romance.

Le **Filtrage** est utilisé lorsque vous souhaitez uniquement afficher les données qui répondent à un critère spécifique et masquer le reste. Le filtrage est vraiment utile lorsque vous disposez de beaucoup de données. Vous pouvez gagner du temps en vous concentrant sur les données vraiment importantes ou celles qui comportent des bogues ou des erreurs. La plupart des feuilles de calcul et des bases de données SQL vous permettent de filtrer vos données de différentes manières. Le filtrage vous donne la possibilité de trouver ce que vous recherchez sans trop d'effort.

Par exemple, si vous souhaitez uniquement savoir qui a regardé des films en octobre, vous pouvez utiliser un filtre sur les dates afin que seuls les enregistrements des films regardés en octobre soient affichés. Ensuite, vous pourrez consulter les noms des personnes pour savoir qui a regardé des films en octobre.

**Dans le processus d'analyse des données, l'objectif de l'analyse est d'identifier les tendances et les relations au sein de ces données afin que vous puissiez répondre avec précision à la question que vous posez.**

Merci d'avoir partagé vos connaissances en attendant plus d'informations.