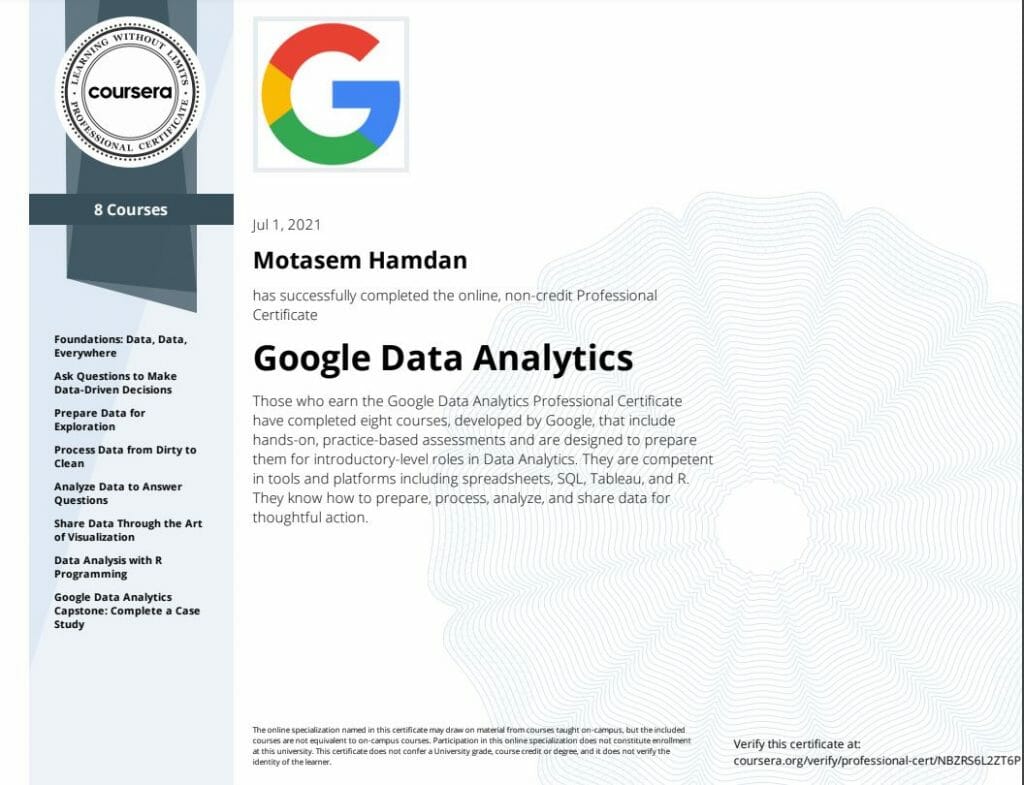

Heute habe ich das Google Data Analytics Professional-Zertifikat

angeboten von Google und Coursera und möchte meine Rezension und Kursnotizen anbieten.

Um das Abschlusszertifikat zu erhalten, müssen Sie acht Kurse absolvieren:

- Grundlagen: Daten, Daten, überall

- Stellen Sie Fragen, um datengestützte Entscheidungen zu treffen

- Daten für die Exploration vorbereiten

- Verarbeiten Sie Daten von schmutzig zu sauber

- Analysieren Sie Daten, um Fragen zu beantworten

- Teilen Sie Daten durch die Kunst der Visualisierung

- Datenanalyse mit R-Programmierung

- Google Data Analytics Capstone: Abschluss einer Fallstudie

Fähigkeiten, die Sie erwerben werden

-

Erlangen Sie ein umfassendes Verständnis der Praktiken und Prozesse, die ein Junior- oder Associate-Datenanalyst in seiner täglichen Arbeit verwendet.

-

Erlernen Sie wichtige analytische Fähigkeiten (Datenbereinigung, -analyse und -visualisierung) und Tools (Tabellenkalkulationen, SQL, R-Programmierung, Tableau).

-

Erfahren Sie, wie Sie Daten für die Analyse bereinigen und organisieren und Analysen und Berechnungen mithilfe von Tabellenkalkulationen, SQL und R-Programmierung durchführen.

-

Erfahren Sie, wie Sie Datenergebnisse in Dashboards, Präsentationen und häufig verwendeten Visualisierungsplattformen visualisieren und präsentieren.

Kaufen Sie den kompletten Data Analytics Notes-Katalog

Das Abschlusszertifikat

Ich habe auch meine Notizen und Zusammenfassungen für jeden Kurs hinzugefügt, einschließlich Codeausschnitten, Konzepten und anderen Dingen, die Sie möglicherweise benötigen, um den Kurs zu bestehen. Fassen Sie zusammen, was Sie gelernt haben, und bewahren Sie die Notizen auf, da sie nützlich sein können, wenn Sie sie brauchen

Sie können meine Sammlung von Zusammenfassungen und Notizen unter den folgenden Links herunterladen:

Videoüberprüfung

Zusammenfassung der Konzepte, die Sie lernen werden:

# Die sechs Schritte im Datenanalyseprozess

Stellen Sie Fragen und definieren Sie das Problem.

Bereiten Sie Daten vor, indem Sie die Informationen sammeln und speichern.

Verarbeiten Sie Daten, indem Sie die Informationen bereinigen und überprüfen.

Analysieren Sie Daten, um Muster, Beziehungen und Trends zu finden.

Teilen Sie Daten mit Ihrem Publikum.

Handeln Sie auf der Grundlage der Daten und nutzen Sie die Analyseergebnisse.

# Daten-Ökosystem

Die verschiedenen Elemente, die miteinander interagieren, um Daten zu erstellen, zu verwalten, zu speichern, zu organisieren, zu analysieren und freizugeben.

# Eine technische Denkweise

Die analytische Fähigkeit, Prozesse in kleinere Schritte zu zerlegen und mit ihnen auf geordnete, logische Weise zu arbeiten

# Datendesign

Analytische Fähigkeiten, die sich darauf beziehen, wie Sie Informationen organisieren

# Datenwissenschaft

Ein Forschungsgebiet, das Rohdaten nutzt, um neue Wege zur Modellierung und zum Verständnis des Unbekannten zu schaffen

# Datenstrategie

Das Management der bei der Datenanalyse eingesetzten Personen, Prozesse und Werkzeuge

# Lückenanalyse

Eine Methode zur Untersuchung und Bewertung des aktuellen Zustands eines Prozesses, um Verbesserungsmöglichkeiten für die Zukunft zu identifizieren.

# Abfragesprache

Eine Computerprogrammiersprache zur Kommunikation mit einer Datenbank

# Datenlebenszyklus vs. Datenanalyse

Der Datenlebenszyklus befasst sich mit den Phasen, die Daten während ihrer Nutzungsdauer durchlaufen; Datenanalyse ist der Prozess der Analyse von Daten.

# Formel vs. Funktion

Eine Formel ist eine Reihe von Anweisungen, die zur Durchführung einer bestimmten Berechnung verwendet werden; eine Funktion ist ein voreingestellter Befehl, der automatisch einen bestimmten Prozess ausführt

# Die sechs Probleme, mit denen ein Datenanalyst arbeitet:

Vorhersagen treffen

Dinge kategorisieren

###### Ein Beispiel für die Kategorisierung von Dingen ist, dass ein Datenanalyst Schlüsselwörter aus Kundenrezensionen identifiziert und sie als positiv oder neutral kennzeichnet.

Etwas Ungewöhnliches entdecken

###### Der Problemtyp „Etwas Ungewöhnliches entdecken“ könnte beinhalten, dass ein Datenanalyst untersucht, warum ein Datensatz einen überraschenden und seltenen Datenpunkt aufweist. Beim Entdecken von etwas Ungewöhnlichem geht es darum, etwas Ungewöhnliches zu identifizieren und zu analysieren.

-Themen identifizieren

###### User Experience (UX)-Designer verlassen sich bei der Analyse von Benutzerinteraktionsdaten möglicherweise auf Analysten. Ähnlich wie bei Problemen, bei denen Analysten Dinge kategorisieren müssen, können Projekte zur Verbesserung der Benutzerfreundlichkeit erfordern, dass Analysten Themen identifizieren, um die richtigen Produktfunktionen für die Verbesserung zu priorisieren. Themen werden am häufigsten verwendet, um Forschern bei der Untersuchung bestimmter Aspekte von Daten zu helfen. In einer Benutzerstudie sind Überzeugungen, Praktiken und Bedürfnisse von Benutzern Beispiele für Themen.

###### Sie fragen sich jetzt vielleicht, ob es einen Unterschied zwischen dem Kategorisieren von Dingen und dem Identifizieren von Themen gibt. Am besten stellen Sie sich das so vor: Beim Kategorisieren von Dingen werden im Allgemeinen dieselben Dinge zusammen klassifiziert, z. B. eine Produktbewertung von 10, während beim Identifizieren von Themen ähnliche Dinge klassifiziert werden, die möglicherweise nicht gleich sind, z. B. positives Benutzerfeedback. Jeder Benutzer sagt etwas anderes, aber sie kommunizieren positive Dinge über das Produkt, was zu einem Thema wird. - Verbindungen entdecken

-Muster finden

###### Bei der Mustersuche geht es darum, Trends in einem Datensatz zu erkennen.

# Intelligente Fragen sind:

-spezifisch: Hat die Frage einen Kontext und geht sie auf das Problem ein? Und helfen die Antworten beim Sammeln von Informationen?

nur auf bestimmte Elemente oder eng verwandte Elemente.

-messbar: Antworten können gemessen und gesammelt werden, um sie zu klassifizieren und zu bewerten, um zu sehen, welche am meisten und am wenigsten

wichtig

-handlungsorientiert: Wenn diese Frage beantwortet wird, hilft sie dabei, Entscheidungen zu treffen, die sich auf die Lösung eines bestimmten Problems oder die Erfindung konzentrieren.

neue Funktion.

-relevant: geht es um das Problem?

-zeitgebunden: werden die Antworten das Problem eher früher als später lösen? kann ein Plan zur Umsetzung erstellt werden

Lösungen, die die Käufer bevorzugen, und bei den unwichtigsten Funktionen Abstriche machen?

# Strukturiertes Denken

Lücken und Chancen aufdecken

Erkennen des aktuellen Problems oder der aktuellen Situation

Organisieren verfügbarer Informationen

# Beim Kategorisieren von Dingen werden Elemente Kategorien zugeordnet. Das Identifizieren von Themen geht einen Schritt weiter und gruppiert sie in breitere Themen oder Klassifizierungen.

# Qualitative vs. quantitative Daten

Qualitative Daten können Analysten helfen, ihre quantitativen Daten besser zu verstehen, indem sie einen Grund oder eine ausführlichere Erklärung liefern. Mit anderen Worten: Quantitative Daten geben Ihnen im Allgemeinen das Was, und qualitative Daten geben Ihnen im Allgemeinen das Warum.

#-Dashboards überwachen eingehende Live-Daten aus mehreren Datensätzen und organisieren die Informationen an einem zentralen Ort.

# Daten vs. Metriken

Daten sind eine Sammlung von Fakten. Metriken sind quantifizierbare Datentypen, die zur Messung verwendet werden

#-Algorithmus

ein Prozess oder eine Reihe von Regeln, die für eine bestimmte Aufgabe befolgt werden müssen

# Metrisch

Eine Metrik ist ein einzelner, quantifizierbarer Datentyp, der beim Setzen und Bewerten von Zielen verwendet wird.

# Strukturiertes Denken ist der Prozess des Erkennens des aktuellen Problems oder der aktuellen Situation, des Organisierens verfügbarer Informationen, des Aufdeckens von Lücken und Möglichkeiten und des Identifizierens von Optionen.

# Funktion vs. Formel

Formeln werden vom Benutzer erstellt, während Funktionen voreingestellte Befehle in Tabellenkalkulationen sind.

# Die vier Fragen für eine effektive Kommunikationsstrategie (hauptsächlich in E-Mails verwendet)

Wer ist Ihr Publikum?

Was wissen sie bereits?

Was müssen sie wissen?

Wie können Sie ihnen am besten mitteilen, was sie wissen müssen?

# Erstanbieterdaten

Daten, die Sie selbst erheben

# Daten von Zweitanbietern

Die Daten werden von einer anderen Gruppe direkt gesammelt und dann verkauft.

# Daten von Drittanbietern

Daten Dritter können aus einer Reihe unterschiedlicher Quellen stammen.

Es handelt sich dabei um den Verkauf von Drittdaten durch einen Anbieter, der die Daten nicht selbst erhoben hat.

# Wenn Sie Ihre eigenen Daten sammeln, treffen Sie vernünftige Entscheidungen über die Stichprobengröße

# Eine Zufallsstichprobe aus vorhandenen Daten kann für einige Projekte ausreichend sein

#-Beobachtung ist die von Wissenschaftlern am häufigsten verwendete Methode zur Datenerfassung.

# Primärdaten

Von einem Forscher aus erster Hand gesammelt

Beispiel: Daten aus einem Interview, das Sie durchgeführt haben

# Sekundärdaten

Von anderen Personen oder aus anderen Forschungsarbeiten gesammelt

Von einer Universität erfasste demografische Daten

# Kontinuierliche Daten

Daten, die gemessen werden und fast jeden numerischen Wert haben können

Körpergröße der Kinder in der dritten Klasse (133 cm, 166 cm)

# Diskrete Daten

Daten, die gezählt werden und eine begrenzte Anzahl von Werten haben

Anzahl der Personen, die täglich ein Krankenhaus aufsuchen (10, 20, 200)

# Nenndaten

Eine Art qualitativer Daten, die nicht in einer festgelegten Reihenfolge kategorisiert sind

Erstkunde, wiederkehrender Kunde, Stammkunde

# Ordinaldaten

Eine Art qualitativer Daten mit einer festgelegten Reihenfolge oder Skala

Filmbewertungen (Anzahl der Sterne: 1 Stern, 2 Sterne, 3 Sterne)

# Strukturierte Daten

Daten, die in einem bestimmten Format organisiert sind, wie Zeilen und Spalten

Spesenabrechnungen

# Unstrukturierte Daten

Daten, die nicht auf eine leicht identifizierbare Weise organisiert sind

Social-Media-Beiträge

# Datenmodellierung ist der Prozess der Erstellung von Diagrammen, die visuell darstellen, wie Daten organisiert und strukturiert sind.

Diese visuellen Darstellungen werden Datenmodelle genannt

# Datenmodellierungstypen

###### Die konzeptionelle Datenmodellierung bietet Ihnen einen Überblick über Ihre Datenstruktur, beispielsweise wie die Daten innerhalb einer Organisation interagieren sollen.

###### Die logische Datenmodellierung konzentriert sich auf die technischen Details des Modells wie Beziehungen, Attribute und Entitäten

###### Die physische Datenmodellierung sollte eigentlich darstellen, wie die Datenbank erstellt wurde. In dieser Phase legen Sie fest, wie jede Datenbank eingerichtet wird und wie die Datenbanken, Anwendungen und Funktionen im Detail interagieren.

# Datenmodellierungstechniken

ERDs sind eine visuelle Möglichkeit, die Beziehung zwischen Entitäten im Datenmodell zu verstehen

UMLs sind sehr detaillierte Diagramme, die die Struktur eines Systems beschreiben, indem sie die Entitäten, Attribute, Operationen und Beziehungen des Systems darstellen.

# Datentransformation ist der Prozess der Änderung des Formats, der Struktur oder der Werte der Daten

# Lange Daten sind Daten, bei denen jede Zeile ein Datenpunkt für ein einzelnes Subjekt ist. Jedes Subjekt hat Daten in mehreren Zeilen.

# Breite Daten sind Daten, in denen jedes Datensubjekt eine einzelne Zeile mit mehreren Spalten für die Werte der verschiedenen Attribute (oder Variablen) des Subjekts hat.

# Der Boolesche Operator „Oder“ erweitert die Anzahl der Ergebnisse bei der Stichwortsuche

# De-Identifizierung

Ein Prozess, der dazu dient, alle personenbezogenen Daten aus Daten zu entfernen

# Eine relationale Datenbank ist eine Datenbank, die eine Reihe von Tabellen enthält, die verbunden werden können, um Beziehungen anzuzeigen.

Im Grunde genommen ermöglichen sie es Datenanalysten, Daten auf der Grundlage gemeinsamer Merkmale zu organisieren und zu verknüpfen.

# Eine relationale Datenbank ist eine Datenbank, die eine Reihe von Tabellen enthält, die verbunden werden können, um Beziehungen anzuzeigen.

Im Grunde genommen ermöglichen sie es Datenanalysten, Daten auf der Grundlage gemeinsamer Merkmale zu organisieren und zu verknüpfen.

# Primärschlüssel

Eine eindeutige Kennung in einer Tabelle, die auf eine Spalte verweist, in der der Wert dieses Schlüssels in jeder Zeile eindeutig ist.

# Fremdschlüssel

Ein Feld in einer Tabelle und ein Primärschlüssel in einer anderen Tabelle.

# Eine Tabelle kann nur einen Primärschlüssel, aber mehrere Fremdschlüssel haben.

Diese Schlüssel stellen die Beziehungen zwischen Tabellen in einer relationalen Datenbank her.

Dies hilft dabei, Daten über mehrere Tabellen in der Datenbank hinweg zu organisieren und zu verbinden.

# Die Normalisierung einer Datenbank ist eine Technik zur Reduzierung der Datenredundanz

# Ein Schema ist eine Möglichkeit zu beschreiben, wie etwas organisiert ist

# Ein Datenbankschema stellt jede Art von Struktur dar, die auf die Datenbank angewendet wird

# Zwei häufig verwendete Schemata sind Sternschemata und Schneeflockenschemata

Das #-Sternschema ist einfach, nicht normalisiert und weist eine hohe Datenredundanz auf

# Ein Snowflake-Schema ist komplex, normalisiert und hat sehr wenig Datenredundanzcy

# Säulendiagramm

Ein Säulendiagramm ist effektiv, um die Unterschiede zwischen mehreren Elementen in einem bestimmten Wertebereich darzustellen.

# Liniendiagramm

Liniendiagramme eignen sich gut zum Darstellen von Trends und Mustern, beispielsweise zur Darstellung von Bevölkerungsveränderungen im Laufe der Zeit.

# Strukturelle Metadaten geben genau an, in wie vielen Sammlungen die Daten vorhanden sind.

Es bietet Informationen darüber, wie ein Datenelement organisiert ist und ob es Teil einer oder mehrerer Datensammlungen ist.

# Data Governance stellt sicher, dass die Datenbestände eines Unternehmens ordnungsgemäß verwaltet werden.

# Das Datum und die Uhrzeit der Erstellung einer Datenbank sind ein Beispiel für administrative Metadaten.

#-Tokenisierung ersetzt die Datenelemente, die Sie schützen möchten, durch zufällig generierte Daten, die als „Token“ bezeichnet werden.

Die Originaldaten werden an einem separaten Ort gespeichert und den Tokens zugeordnet.

Um auf die vollständigen Originaldaten zugreifen zu können, muss der Benutzer oder die Anwendung über die Berechtigung zur Verwendung der tokenisierten Daten und der Token-Zuordnung verfügen.

Dies bedeutet, dass selbst wenn die tokenisierten Daten gehackt werden, die Originaldaten weiterhin sicher an einem separaten Ort verbleiben.

**Datenanalysten sollten über die Änderung eines Geschäftsziels nachdenken, wenn die Daten nicht mit dem ursprünglichen Ziel übereinstimmen und wenn nicht genügend Daten vorhanden sind, um das Ziel zu erreichen**

**Die für die Analyse verwendeten Daten sollten mit den Geschäftszielen übereinstimmen und dazu beitragen, die Fragen der Stakeholder zu beantworten**

# Was tun, wenn Sie ein Problem mit Ihren Daten feststellen?

## Datenproblem 1: Keine Daten

Wenn keine Zeit zum Sammeln von Daten bleibt, führen Sie die Analyse mit Proxydaten aus anderen Datensätzen durch. _Dies ist die gängigste Problemumgehung._

Wenn Sie die Hauptreisezeiten für Pendler analysieren, Ihnen aber die Daten für eine bestimmte Stadt fehlen, verwenden Sie die Daten einer anderen Stadt mit ähnlicher Größe und Bevölkerungsstruktur.

## Datenproblem 2: zu wenige Daten

Führen Sie die Analyse mithilfe von Proxydaten und tatsächlichen Daten durch.

Wenn Sie Trends für Besitzer von Golden Retrievern analysieren, erweitern Sie Ihren Datensatz, indem Sie die Daten von Besitzern von Labradoren einbeziehen.

Passen Sie Ihre Analyse an die Daten an, die Sie bereits haben.

Wenn Ihnen Daten für 18- bis 24-Jährige fehlen, führen Sie die Analyse durch, beachten Sie in Ihrem Bericht jedoch die folgende Einschränkung: _Diese Schlussfolgerung gilt nur für Erwachsene ab 25 Jahren_.

## Datenproblem 3: falsche Daten, einschließlich Daten mit Fehlern

Mögliche Lösungen

Wenn Ihnen aufgrund von Missverständnissen der Anforderungen falsche Daten vorliegen, kommunizieren Sie die Anforderungen erneut.

Wenn Sie die Daten zu weiblichen Wählern benötigen und die Daten zu männlichen Wählern erhalten haben, formulieren Sie Ihren Bedarf erneut.

Identifizieren Sie Fehler in den Daten und korrigieren Sie diese, wenn möglich, an der Quelle, indem Sie nach einem Muster in den Fehlern suchen.

Wenn sich Ihre Daten in einer Kalkulationstabelle befinden und eine bedingte Anweisung oder ein Boolescher Wert vorhanden ist, der zu falschen Berechnungen führt, ändern Sie die bedingte Anweisung, anstatt nur die berechneten Werte zu korrigieren.

Wenn Sie Datenfehler nicht selbst korrigieren können, können Sie die falschen Daten ignorieren und mit der Analyse fortfahren, sofern Ihre Stichprobengröße noch groß genug ist und das Ignorieren der Daten nicht zu einer systematischen Verzerrung führt.

Wenn Ihr Datensatz aus einer anderen Sprache übersetzt wurde und einige der Übersetzungen keinen Sinn ergeben, ignorieren Sie die Daten mit der schlechten Übersetzung und fahren Sie mit der Analyse der anderen Daten fort.

![[Datensammlungsnotizen.jpg]]

**Bevölkerung**

Die gesamte Gruppe, die Sie für Ihre Studie interessiert. Wenn Sie beispielsweise Personen in Ihrem Unternehmen befragen, wäre die Grundgesamtheit alle Mitarbeiter Ihres Unternehmens.

**Probe**

Eine Teilmenge Ihrer Bevölkerung. Genau wie eine Lebensmittelprobe wird sie als Probe bezeichnet, weil sie nur einen Vorgeschmack darstellt. Wenn Ihr Unternehmen also zu groß ist, um jede einzelne Person zu befragen, können Sie eine repräsentative Stichprobe Ihrer Bevölkerung befragen.

**Fehlermarge**

Da eine Stichprobe zur Darstellung einer Population verwendet wird, ist zu erwarten, dass die Ergebnisse der Stichprobe von dem Ergebnis abweichen, das Sie bei einer Befragung der gesamten Population erhalten hätten. Diese Differenz wird als Fehlerspanne bezeichnet. Je kleiner die Fehlerspanne, desto näher liegen die Ergebnisse der Stichprobe an dem Ergebnis, das Sie bei einer Befragung der gesamten Population erhalten hätten.

Die Fehlerspanne wird verwendet, um zu bestimmen, wie nahe das Ergebnis Ihrer Stichprobe an dem Ergebnis liegt, das wahrscheinlich ausgefallen wäre, wenn Sie die gesamte Population hätten befragen oder testen können. Die Fehlerspanne hilft Ihnen, Umfrage- oder Testergebnisse im wirklichen Leben zu verstehen und zu interpretieren. Die Berechnung der Fehlerspanne ist besonders hilfreich, wenn Sie die zu analysierenden Daten erhalten. Nachdem Sie die Fehlerspanne mit einem Rechner berechnet haben, wissen Sie, wie stark die Stichprobenergebnisse von den Ergebnissen der gesamten Population abweichen können.

**Vertrauensniveau**

Wie zuversichtlich Sie in Bezug auf die Umfrageergebnisse sind. Ein Konfidenzniveau von 95% bedeutet beispielsweise, dass Sie, wenn Sie die gleiche Umfrage 100 Mal durchführen würden, bei 95 dieser 100 Malen ähnliche Ergebnisse erhalten würden. Das Konfidenzniveau wird vor Beginn Ihrer Studie ermittelt, da es sich darauf auswirkt, wie groß Ihre Fehlerquote am Ende Ihrer Studie ist.

In den meisten Fällen wird ein Konfidenzniveau von 90% oder 95% verwendet. Abhängig von Ihrer Branche möchten Sie jedoch möglicherweise ein strengeres Konfidenzniveau festlegen. Ein Konfidenzniveau von 99% ist in einigen Branchen sinnvoll, beispielsweise in der Pharmaindustrie.

**Konfidenzintervall**

Der Bereich möglicher Werte, in dem das Ergebnis der Population auf dem Konfidenzniveau der Studie liegen würde. Dieser Bereich ist das Stichprobenergebnis +/- der Fehlerspanne.

**Statistische Signifikanz**

Die Feststellung, ob Ihr Ergebnis auf Zufall beruhen könnte oder nicht. Je größer die Signifikanz, desto weniger Zufall.

**Damit ein Experiment statistisch signifikant ist, müssen die Ergebnisse real und nicht durch Zufall verursacht sein.**

**Um bei einer Kundenbefragung ein hohes Maß an Vertrauen zu erreichen, sollte die Stichprobengröße die gesamte Grundgesamtheit genau widerspiegeln.**

## Arten von fehlerhaften Daten

Doppelte Daten

Veraltete Daten

Unvollständige Daten

Falsche/ungenaue Daten

Inkonsistente Daten

**Eine Null gibt an, dass ein Wert nicht existiert. Eine Null ist eine numerische Antwort.**

**Beim Datenmapping handelt es sich um den Vorgang, Felder einer Datenquelle einer anderen zuzuordnen.**

#-Dokumentation

Ingenieure verwenden **Engineering Change Orders** (ECOs), um neue Produktdesigndetails und vorgeschlagene Änderungen an bestehenden Produkten zu verfolgen. Autoren verwenden **Dokumentrevisionshistorien**, um Änderungen am Dokumentfluss und an Bearbeitungen zu verfolgen. Und Datenanalysten verwenden **Änderungsprotokolle**, um die Datentransformation und -bereinigung zu verfolgen.

Änderungsprotokolle sind sehr hilfreich, um die Gründe für Änderungen zu verstehen. Änderungsprotokolle haben kein festgelegtes Format und Sie können Ihre Einträge sogar in einem leeren Dokument vornehmen. Wenn Sie jedoch ein gemeinsam genutztes Änderungsprotokoll verwenden, sollten Sie sich am besten mit anderen Datenanalysten auf das Format aller Ihrer Protokolleinträge einigen.

Ein Junior-Analyst muss wahrscheinlich nur das oben Genannte wissen, mit einer Ausnahme. Wenn ein Analyst Änderungen an einer vorhandenen SQL-Abfrage vornimmt, die im gesamten Unternehmen verwendet wird, verwendet das Unternehmen höchstwahrscheinlich ein sogenanntes **Versionskontrollsystem**. Ein Beispiel könnte eine Abfrage sein, die den täglichen Umsatz abruft, um ein Dashboard für das obere Management zu erstellen.

# Versionskontrollsystem

So wirkt sich ein Versionskontrollsystem auf eine Änderung einer Abfrage aus:

1. Ein Unternehmen verfügt über offizielle Versionen wichtiger Abfragen in seinem **Versionskontrollsystem**.

2. Ein Analyst stellt sicher, dass die aktuellste Version der Abfrage diejenige ist, die er ändern wird. Dies nennt man **Synchronisieren**

3. Der Analyst nimmt eine Änderung an der Abfrage vor.

4. Der Analyst kann jemanden bitten, diese Änderung zu überprüfen. Dies wird als **Codeüberprüfung** bezeichnet und kann informell oder formell erfolgen. Eine informelle Überprüfung kann ganz einfach darin bestehen, einen erfahrenen Analysten zu bitten, sich die Änderung anzusehen.

5. Nachdem ein Prüfer die Änderung genehmigt hat, übermittelt der Analyst die aktualisierte Version der Abfrage an ein Repository in

6. das Versionskontrollsystem des Unternehmens. Dies wird als **Code-Commit** bezeichnet. Eine bewährte Vorgehensweise besteht darin, in einem Kommentarbereich genau zu dokumentieren, was die Änderung war und warum sie vorgenommen wurde. Zurück zu unserem Beispiel einer Abfrage, die den täglichen Umsatz abruft. Ein Kommentar könnte lauten: _Aktualisierter Umsatz, um den Umsatz aus dem neuen Produkt Calypso einzuschließen_.

7. Nachdem die Änderung **übermittelt** wurde, kann jeder andere im Unternehmen auf diese neue Abfrage zugreifen und sie verwenden, wenn er eine **Synchronisierung** mit den aktuellsten Abfragen durchführt, die im Versionskontrollsystem gespeichert sind.

8. Wenn bei der Abfrage ein Problem auftritt oder sich die Geschäftsanforderungen ändern, kann der Analyst die Änderung an der Abfrage mithilfe des Versionskontrollsystems **_rückgängig machen_**. Der Analyst kann sich eine chronologische Liste aller an der Abfrage vorgenommenen Änderungen ansehen und angeben, wer die jeweilige Änderung vorgenommen hat. Nachdem der Analyst dann seine eigene Änderung gefunden hat, kann er zur vorherigen Version **zurückkehren**.

9. Die Abfrage ist wieder in dem Zustand, in dem sie war, bevor der Analyst die Änderung vorgenommen hat. Und jeder im Unternehmen sieht diese wiederhergestellte, ursprüngliche Abfrage ebenfalls.

Wenn nicht genügend Daten vorliegen, um langfristige Trends zu erkennen, besteht eine Möglichkeit darin, mit den Stakeholdern zu sprechen und sie zu bitten, das Ziel anzupassen. Sie könnten auch darum bitten, auf weitere Daten zu warten und einen aktualisierten Zeitplan bereitzustellen.

**Ausreißer** sind Datenpunkte, die sich stark von ähnlich erfassten Daten unterscheiden und möglicherweise keine zuverlässigen Werte darstellen.

## Sortieren versus Filtern

**Sortieren** bedeutet, dass Sie Daten in eine sinnvolle Reihenfolge bringen, um sie leichter verständlich, analysierbar und visualisierbar zu machen. Dabei werden Ihre Daten anhand einer bestimmten, von Ihnen gewählten Metrik geordnet. Sie können Daten in Tabellenkalkulationen, SQL-Datenbanken (wenn Ihr Datensatz zu groß für Tabellenkalkulationen ist) und Tabellen in Dokumenten sortieren.

Wenn Sie beispielsweise Dinge bewerten oder chronologische Listen erstellen müssen, können Sie in aufsteigender oder absteigender Reihenfolge sortieren. Wenn Sie die Lieblingsfilme einer Gruppe herausfinden möchten, können Sie nach Filmtitel sortieren, um dies herauszufinden. Durch das Sortieren werden die Daten auf sinnvolle Weise angeordnet und Sie erhalten sofortige Erkenntnisse. Durch das Sortieren können Sie auch ähnliche Daten nach einer Klassifizierung gruppieren. Bei Filmen können Sie nach Genre sortieren – beispielsweise Action, Drama, Science-Fiction oder Liebesfilm.

**Filtern** wird verwendet, wenn Sie nur Daten sehen möchten, die ein bestimmtes Kriterium erfüllen, und den Rest ausblenden möchten. Filtern ist wirklich nützlich, wenn Sie viele Daten haben. Sie können Zeit sparen, indem Sie sich auf die Daten konzentrieren, die wirklich wichtig sind oder die Fehler oder Mängel aufweisen. Die meisten Tabellenkalkulationen und SQL-Datenbanken ermöglichen es Ihnen, Ihre Daten auf verschiedene Weise zu filtern. Durch Filtern können Sie ohne großen Aufwand finden, wonach Sie suchen.

Wenn Sie beispielsweise nur wissen möchten, wer im Oktober Filme gesehen hat, können Sie einen Filter für die Daten verwenden, sodass nur die Datensätze für im Oktober gesehene Filme angezeigt werden. Anschließend können Sie die Namen der Personen überprüfen, um herauszufinden, wer im Oktober Filme gesehen hat.

**Das Ziel der Datenanalyse besteht darin, Trends und Beziehungen innerhalb der Daten zu erkennen, damit Sie Ihre Frage präzise beantworten können.**

Vielen Dank für die Weitergabe Ihres Wissens. Ich freue mich auf weitere Informationen.